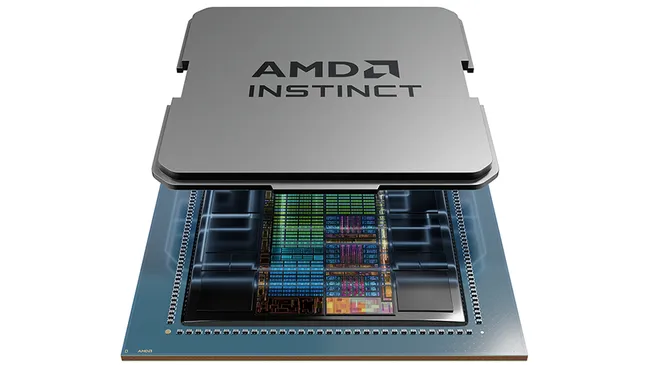

近日,甲骨文云基础设施(Oracle Cloud Infrastructure, OCI)宣布,将采用AMD的Instinct MI300X系列GPU,以增强其在人工智能(AI)工作负载处理方面的能力。这一举措标志着AMD在云服务提供商市场中取得了又一重大胜利,同时也展示了OCI对于高性能AI硬件的需求和承诺。

AMD的Instinct MI300X是一款性能强大的AI加速器,它被设计用于支持大规模的AI模型训练和推理工作。OCI计划将其整合到新的OCI Compute Supercluster实例中,具体型号为BM.GPU.MI300X.8。这个新的超级集群旨在处理包含数十亿参数的庞大AI模型,并能够在单个集群中支持多达16,384个GPU。

AMD的Instinct MI300X GPU在性能测试中表现出色。在Llama 2 70B模型的测试中,MI300X实现了65毫秒的“首个token时间”,并且在256个并发用户请求中,能够有效地扩展以生成3,643个token。在另一项测试中,它在2,048个输入和128个输出token的情况下,提供了1.6秒的端到端延迟,与AMD自己的基准测试结果非常接近。

OCI的BM.GPU.MI300X.8实例配备了8个AMD Instinct MI300X加速器,提供了1.5TB的HBM3 GPU内存,带宽达到5.3TB/s。此外,该实例还配备了2TB的系统内存和8个3.84TB的NVMe存储。甲骨文将为每个GPU每小时提供6美元的裸金属解决方案。

甲骨文云基础设施的高级副总裁Donald Lu表示:“AMD Instinct MI300X加速器的推理能力,增加了OCI在高性能裸金属实例选择上的深度,消除了通常用于AI基础设施的虚拟化计算开销。”他补充说:“我们很高兴能为客户提供更多选择,以具有竞争力的价格加速AI工作负载。”

总的来说,OCI通过引入AMD的Instinct MI300X GPU,进一步扩展了其在AI领域的服务能力,为需要处理大规模AI工作负载的企业提供了一个强大的平台。这一合作不仅加强了OCI在AI领域的竞争力,也为AMD在云服务市场中的进一步扩张铺平了道路。

原文作者:Wayne Williams

2024年10月12日

想了解更多资讯

扫码关注👇

了解更多考试相关

扫码添加上智启元官方客服微信👇

17认证网

17认证网